Explainable Artificial Intelligence: Licht in die Black Box bringen

13.09.2023 | News Business Intelligence Know-how Letter

Einleitung

Bei Themen wie den Einsatz von Methoden künstlicher Intelligenz denkt man sicher nicht in erster Linie an Unternehmen aus der Finanzbranche. Aber häufig sind es gerade Finanzinstitute, die neue und hochmoderne Technologien wie z. B. künstliche Intelligenz (KI) früh übernehmen, was vor allem auf die stark wettbewerbsorientierte Natur der Finanzmärkte zurückzuführen ist, in denen sie agieren.

Zudem gibt es auf der regulatorischen Seite ständig steigende Anforderungen an diese Institute, wie beispielsweise die schnell wachsenden Basel Anforderungen für Banken und die Solvency II Anforderungen in der Versicherungsbranche, die sie dazu zwingen, ihren Technologiebedarf zu überdenken und zu modernisieren.

An der Technologiefront haben sich diese Institute daher zunehmend in datengetriebene Unternehmen verwandelt, die eine Reihe von fortschrittlichen Tools nutzen, wie z. B. Data Warehouses (DWHs), Cloud-Technologien [NC], maschinelle Lernalgorithmen (MLAs) [NC], Automatisierungstools [NC], Customer-Relationship-Management (CRM) und Enterprise- Resource-Planning (ERP) Tools.

Die vielversprechendste und doch zugleich am schwersten fassbare dieser Technologien, die Finanzinstitute in vielerlei Hinsicht verbessern könnte, ist jedoch zweifellos die KI (englisch Artificial Intelligence (AI)). Obwohl KI-Methoden revolutionär sind, gelten sie im Allgemeinen doch als Black Box. In diesem Artikel wollen wir zeigen, dass KI nicht unbedingt immer eine Black Box sein muss, sondern dass die Entscheidungsprozesse der KI-Algorithmen transparenter gestaltet werden können und damit eine regelkonforme, vertrauenswürdige und erkenntnisgetriebene KI-Entwicklung und -Nutzung ermöglichen.

Ein zentraler Punkt der Regulierung von KI seitens der Aufsichtsbehörden ist ebenfalls die Transparenz und Nachvollziehbarkeit der komplexen KI-Modelle. Ein Beispiel hierfür ist der neue EU AI Act der Europäischen Union (EU).1

Um einen Überblick über die möglichen Vorteile von KI in der Finanzbranche zu geben und zu zeigen, wie KI in der Finanzindustrie aktiv und regelkonform genutzt werden kann, haben wir diesen Artikel in folgende Abschnitte unterteilt.

Nach einer Übersicht von bereits im Einsatz befindlichen KI Use-Cases in der Finanzbranche, stellen wir die bevorstehenden Herausforderungen für die Umsetzung von KI-Systemen durch den neuen KI-regulatorischen Rahmen, der von der EU vorgeschlagen wurde, vor und zeigen im letzten Abschnitt einige Techniken, um KI-Methoden erklären und diese Herausforderungen bewältigen zu können.

Anwendungsfälle von KI in der Finanzindustrie

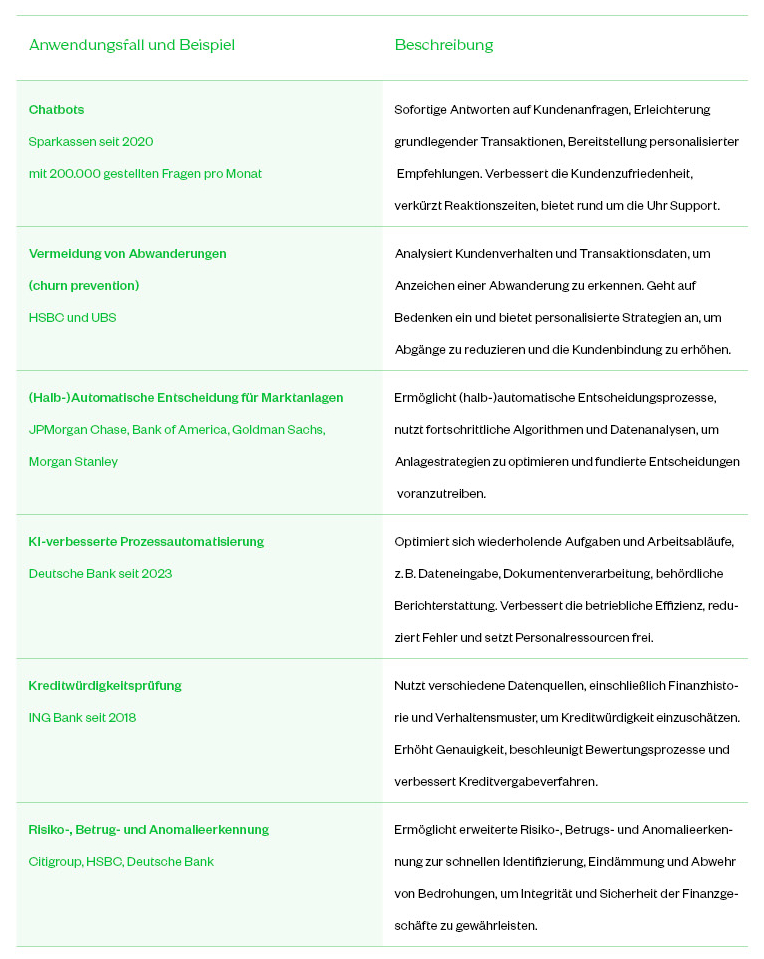

Schon vor dem Hype um Chat-GPT hatten KI-Anwendungsfälle viele Bereiche moderner Finanzinstitute durchdrungen, von Back- bis Front-Office und von der Unterstützung operativer Tätigkeiten bis hin zu strategischen Themen sowie Entscheidungsfindung. Einige der bedeutendsten Anwendungsfälle in der Finanzbranche sind in Tabelle 1 detailliert dargestellt.

Daneben gibt es noch viele andere Anwendungsfälle, die sich in den Anfangsstadien der Entwicklung befinden. Bisher hat die fehlende regulatorische Klarheit es den meisten KI-Tools ermöglicht, fast widerstandsfrei live zu gehen. Doch die sich verändernde regulatorische Landschaft erfordert mehr Transparenz im Entscheidungsprozess von KI-Anwendungen und zwingt Entwickler, bestimmte Standards einzuhalten. Im folgenden Abschnitt werfen wir daher einen kurzen Blick auf den EU AI Act.

Erste ganzheitliche Regulierung

von KI: EU AI Act

KI-Techniken wie Large Language Models (LLMs) und Generative Pre-Trained Transformers (GPTs) haben das Potenzial, Aufgaben zu automatisieren, die Entscheidungsfindung zu verbessern und Wettbewerbsvorteile zu schaffen. Das volle Ausmaß ihres Einflusses und ihrer disruptiven Kraft auf unsere Gesellschaft ist jedoch noch unbekannt, was auch in der inhärenten Undurchsichtigkeit der KI-Tools begründet ist. Zudem fehlt in der Finanzbranche noch weitgehend ein regulatorischer Rahmen für KI. Um dieses Problem anzugehen, ergreift die EU entschlossene Maßnahmen mit der Einführung des EU AI Act, der bis Ende 2023 abgeschlossen sein soll.2

Gemäß dem EU AI Act werden Tools basierend auf der KI-Funktionalität in drei Risikogruppen eingeteilt. Diese Risikogruppen sind inakzeptables Risiko, hohes Risiko und begrenztes Risiko.3 Ein Beispiel für die Kategorie des inakzeptablen Risikos wäre ein von der Regierung betriebenes Social-Scoring-Tool. In die Gruppe des hohen Risikos fallen weit verbreitete CV-Scanning- oder Kreditbewertungsalgorithmen. Jede Gruppe hat ihre eigene Regelung. Wichtig zu beachten ist, dass sowohl der Nutzer als auch der Anbieter solcher Tools von diesem Gesetz betroffen sind. Trotz all dieser Entwicklungen ist es dennoch nicht einfach, KI zu beherrschen. Wie Tristan Harris vom Center for Humane Technology es ausdrückt:4

„ … mit einer neuen Technologie entdecken wir eine neue Klasse von Verantwortung. Wir brauchten das Recht auf Vergessenwerden nicht, bis Computer sich an uns für immer erinnern konnten, und wir brauchten das Recht auf Privatsphäre in unseren Gesetzen nicht, bis Kameras massenproduziert wurden.“

In diesem Sinne ist KI nicht anders und das Ziel ist es, diese neuen Klassen von Verantwortlichkeiten zu identifizieren, ohne Innovationen zu ersticken. Angesichts dieser Entwicklungen werden wir im folgenden Abschnitt einige Methoden vorstellen, die hilfreich sind, um den Entscheidungsprozess der KI zu verstehen, und damit ihre Transparenz zu erhöhen.

Explainable AI

Die Methoden, die KI erklärbar machen, können unter dem Begriff Explainable AI (XAI - auch bekannt als Interpretable Machine Learning) zusammengefasst werden. Diese Techniken können überall dort angewendet werden, wo KI präsent ist, und bieten wertvolle Lösungen, um verschiedene Herausforderungen im gesamten KI-Entwicklungszyklus zu bewältigen. Die Herausforderungen umfassen dabei sowohl ethische Bedenken wie Voreingenommenheit, Fairness und Datenschutz, als auch technische Fragen in Bezug auf Datenqualität, Training, Verbesserung und Debugging.

XAI dient einem umfassenden Satz von Zielen. Ausgehend von wissenschaftlichen Quellen 3 5 6 haben wir sechs Schlüsselaspekte identifiziert, die in Abbildung 1 dargestellt sind. Transparenz bedeutet, dass Menschen in der Lage sind, die inneren Abläufe des Systems zu verstehen. Vertrauenswürdigkeit wird erreicht, indem Erklärungen für die Entscheidungen und Handlungen der KI gegeben werden. Interpretierbarkeit stellt sicher, dass Fachexperten die Gründe für bestimmte Entscheidungen oder Handlungen nachvollziehen können.

Diese Aspekte erleichtern die menschliche Aufsicht, etablieren Mechanismen zur Fehlerberichterstattung und -korrektur, fördern die Rechenschaftspflicht und die Einhaltung ethischer und rechtlicher Standards. Schließlich ermöglicht ein tiefes Verständnis der KI schrittweise Verfeinerungen und Verbesserungen, erhöht die Skalierbarkeit und die potenzielle Anwendbarkeit auf benachbarte Bereiche. Lassen Sie uns einen Blick auf verschiedene Strategien werfen, um ML und KI interpretierbar zu machen.

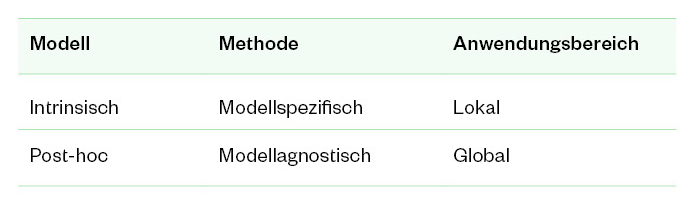

Strategien zur Verbesserung der Interpretierbarkeit von ML-Algorithmen können grob in zwei Hauptansätze unterteilt werden: intrinsische und post-hoc.7 Zusätzlich gibt es aus Anwendungssicht zwei verschiedene Perspektiven: modellspezifisch und modellagnostisch.7 Der Anwendungsbereich dieser Methoden umfasst sowohl die lokale als auch die globale Interpretierbarkeit, siehe Tabelle 2.

Im Folgenden werden wir kurz intrinsische modellspezifische und post-hoc modellagnostische Methoden vorstellen, da diese die einfachsten zu interpretierenden und damit die vielversprechendsten Methoden zur Bewältigung der Herausforderungen des EU AI Acts sind.

Intrinsische XAI-Ansätze konzentrieren sich auf die Nutzung der Modellinterna und setzen Techniken ein, um proaktiv die Komplexität des Modells zu begrenzen. So kann beispielsweise in einer polynomialen Regression die Anzahl der Merkmale oder der Grad der zulässigen Polynome einschränkt werden, um die Erklärungsfreundlichkeit zu fördern. Diese Methoden sind modellspezifisch, da jedes Modell seine eigenen technischen Überlegungen erfordert .

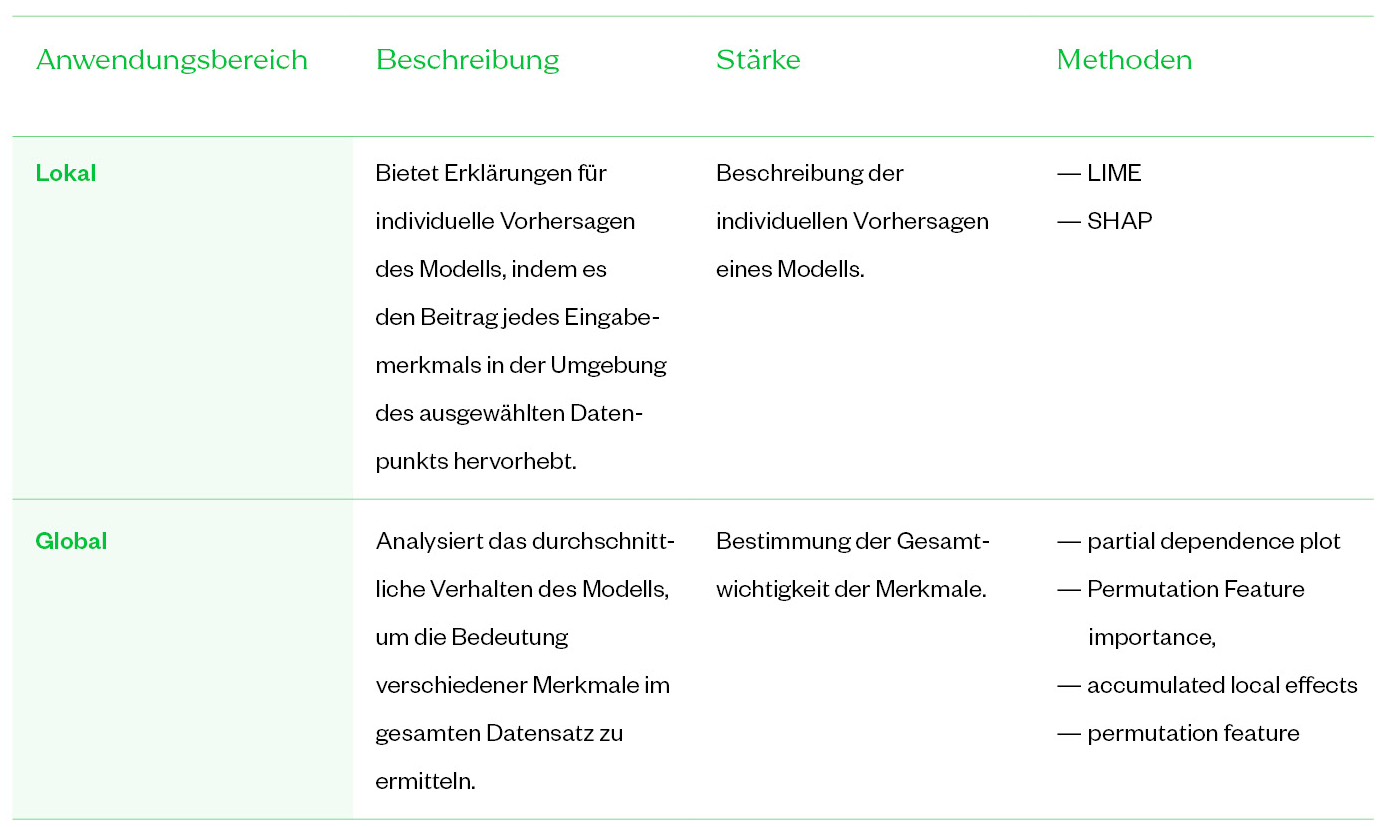

Auf der anderen Seite arbeiten post-hoc-Methoden mit vortrainierten Algorithmen und bestimmen die Wichtigkeit von Merkmalen, indem z. B. der Wert eines Merkmals verändert und die Auswirkung auf das Ergebnis beobachtet wird. Auf diese Weise kann die Wichtigkeit jedes Merkmals abgeleitet werden. Diese Methoden sind modellagnostisch und können je nach ihrem jeweiligen Geltungsbereich weiter in lokale und globale Ansätze unterteilt werden.7

Tabelle 3 gibt einen Überblick über die für XAI verfügbaren Methoden. Auf einige dieser Techniken gehen wir im Folgenden näher ein.

Intrinsisch interpretierbare, modellspezifische Methoden

Wie bereits erwähnt, verfügen intrinsisch interpretierbare Modelle über eingebaute Mechanismen, die die Anpassung der Modellkomplexität erleichtern. Die Schlüsselmodelle für intrinsische Interpretierbarkeit umfassen lineare Regression, logistische Regression, verallgemeinerte lineare Modelle und Entscheidungsbäume.

Zum Beispiel kann im Falle von linearen Modellen verschiedene Techniken anwendet werden, um die Interpretierbarkeit zu verbessern, einschließlich, aber nicht beschränkt auf:

Merkmalsauswahl: Auswahl einer Teilmenge relevanter Merkmale, die einen signifikanten Beitrag zu den Vorhersagen des Modells leisten, z.B. durch Nutzung von K-Mean oder selbstorganisierenden Karten. Dies hilft, das Modell zu vereinfachen, die Leistung und seine Erklärbarkeit zu verbessern.

Koeffizientenanalyse: Durch Analyse der Koeffizienten des linearen Regressionsmodells kann man den Einfluss jedes Merkmals auf das prognostizierte Ergebnis verstehen. Positive oder negative Koeffizienten zeigen die Richtung und das Ausmaß des Einflusses an.

Post-hoc modellagnostische Methoden

Trotz ihrer breiten Anwendbarkeit erfordern modellagnostische Methoden eine sorgfältige Überlegung hinsichtlich ihrer Generalisierungsfähigkeiten. Diese Methoden können mit jedem Maschinenlernmodell verwendet werden, unabhängig von seiner zugrunde liegenden Architektur oder Komplexität.7 8

Betrachten wir zwei prominente lokale modellagnostische Methoden:

- LIME (Lokale Interpretierbare Modellagnostische Erklärungen):8 LIME bestimmt die Merkmalswichtigkeit, indem es intrinsisch interpretierbare Modelle, wie lineare Approximationen, in der Nähe einer Entscheidungsgrenze nutzt. Es erstellt lokale Ersatzmodelle, die das Verhalten des ursprünglichen komplexen Modells nachahmen. Durch Analyse des Verhaltens dieser vereinfachten Modelle liefert LIME Einblicke in die relative Wichtigkeit verschiedener Merkmale für einzelne Vorhersagen.7

- SHAP (SHapley Additive exPlanations):9 SHAP bestimmt die Merkmalswichtigkeit mithilfe von Shapley-Werten, einem Konzept aus der kooperativen Spieltheorie. Es berechnet den durchschnittlichen marginalen Beitrag jedes Merkmalswerts über alle möglichen Kombinationen oder Koalitionen von Merkmalen.7 Durch Quantifizierung des Beitrags jedes Merkmals zum Vorhersageergebnis bietet SHAP ein umfassendes Verständnis der Merkmalswichtigkeit auf modellagnostische Weise.

In einem der nachfolgenden NC-Newsletter werden wir näher auf die Funktionsweise von LIME und SHAP eingehen.

Modellagnostische Methoden erleichtern die Interpretierbarkeit über verschiedene Maschinenlernmodelle hinweg, fördern Transparenz und liefern wertvolle Einblicke in den Entscheidungsprozess. Dennoch ist es unerlässlich, den Grad zu bestimmen, in dem ihre Interpretationen über den spezifischen Datensatz oder das Modell, das analysiert wird, hinaus angewendet werden können. Diese Bewertung stellt sicher, dass die aus diesen Methoden gewonnenen Erkenntnisse gültig und in breiteren Kontexten anwendbar sind, wodurch ihre allgemeine Zuverlässigkeit und Nützlichkeit gestärkt werden.

Auswahlkriterium

Das Auswahlkriterium für XAI-Methoden hängt von den Eigenschaften des KI-Algorithmus und den spezifischen Anforderungen der vorliegenden Aufgabe ab. Verschiedene Faktoren sollten berücksichtigt werden, um die Eignung einer Erklärungsmethode zu bestimmen.

Wir haben die folgenden Faktoren identifiziert (siehe z. B.10):

- Modellkomplexität: Betrachten Sie die Komplexität des MLA selbst. Für einfachere MLAs sind intrinsisch interpretierbare Modelle möglicherweise besser geeignet. Bei komplexeren MLAs werden oft post-hoc-Methoden bevorzugt.

- Gewünschter Grad an Erklärbarkeit: Bestimmen Sie die spezifischen Ziele der Erklärbarkeit im gegebenen Kontext. Verschiedene XAI-Methoden stechen bei unterschiedlichen Aspekten heraus, wie z.B. das Verstehen individueller Vorhersagen oder das Bestimmen der globalen Merkmalswichtigkeit.

- Ausmaß der Fachkompetenz: Bewerten Sie die verfügbare Fachkompetenz. Einige Methoden erfordern ein tieferes Verständnis des zugrunde liegenden Modells oder fachspezifisches Wissen, während andere so konzipiert sind, dass sie auch für Nicht-Experten zugänglich sind.

- Effizienz: Bewerten Sie die Rechenanforderungen der XAI-Methoden. Betrachten Sie die Effizienz der Methoden, insbesondere bei der Verarbeitung großer Datensätze oder Echtzeitanwendungen.

- Trade-offs: Erkennen Sie die Trade-offs zwischen Interpretierbarkeit, Genauigkeit und Einfachheit. Verschiedene XAI-Methoden können eine unterschiedliche Gewichtung zwischen diesen Faktoren haben. Fachleute sollten diese Trade-offs bewerten, um die Methode auszuwählen, die ihren Präferenzen und Anforderungen entspricht.

Durch sorgfältige Berücksichtigung dieser Faktoren und Bewertung der Eigenschaften der XAI-Methoden für den KI-Algorithmus und den KI-Algorithmus selbst, können Fachleute die am besten geeignete Methode auswählen, um ihre spezifischen Anforderungen zu erfüllen und die Interpretierbarkeit des Maschinenlernsystems zu verbessern.

Fazit

Die zunehmende Verwendung von künstlicher Intelligenz (KI) in der Finanzbranche bedingt unmittelbar die dringende Notwendigkeit von Transparenz und Interpretierbarkeit in KI-Systemen. Die Einführung des AI-Acts der Europäischen Union und die sich ausweitende regulatorische Landschaft dienen als Katalysator für Erklärbarkeit und Rechenschaftspflicht in KI-Entscheidungsprozessen. Das Gebiet der Explainable AI (XAI) bietet eine Reihe wertvoller Techniken, um Herausforderungen wie Voreingenommenheit, Fairness, Datenschutz und Datenqualität in der KI-Entwicklung anzugehen. Darüber hinaus hat es das Potenzial, bisher unbekannte Beziehungen innerhalb von Daten aufzudecken und Organisationen einen Wettbewerbsvorteil zu verschaffen. Kontaktieren Sie uns, um mehr über XAI zu erfahren und wie Sie KI- und XAI-Techniken effektiv in Ihrem Unternehmen implementieren können.

Bei Interesse an einem Austausch zu diesem oder ähnlichen Themen rund um die Themen Regulatory Reporting sowie Risiko können Sie sich gerne jederzeit bei den Autoren dieses Artikels melden.

Literaturverzeichnis

1 „The Artificial Intelligence Act,“ 2023. Available: https://artificialintelligenceact.eu/

2 „EU AI Act: first regulation on artificial intelligence,“ 2023. Available: https://www.europarl.europa.eu/news/en/headlines/socieety/20230601STO93804/eu-ai-act-first-regulation-on-artificial-intelligence

3 Christian Meske, „Explainable Artificial Intelligence: Objectives, Stakeholders, and Future Research Opportunities,“ 2020. Available: https://www.tandfonline.com/doi/full/10.1080/10580530.2020.1849465

4 The Three Rules of Humane Tech. [Sound Recording]. "The Center for Humane Technology," 2023.

5 VERA LIAO, „Human-Centered Explainable AI (XAI): From Algorithms to User Experiences,“ 2022. Available: https://arxiv.org/abs/2110.10790

6 Krzysztof Fiok, „Explainable artificial intelligence for education and training,“ 2021. Available: https://journals.sagepub.com/doi/10.1177/15485129211028651

7 C. Molnar, "Interpretable Machine Learning," 2023. Available: https://christophm.github.io/interpretable-ml-book

8 Marco Tulio Ribeiro, „Why Should I Trust You?: Explaining the Predictions of Any Classifier,“ 2016. Available: https://arxiv.org/abs/1602.04938

9 L. Lundberg, „A unified approach to interpreting model predictions,“ 2017. Available: https://arxiv.org/abs/1705.07874

10 Tom Vermeire, „How to choose an Explainability Method? Towards a Methodical Implementation of XAI in Practice,“ 2021. Available: https://arxiv.org/abs/2107.04427