Machine Learning im Kreditrisikomanagement (II): Textmining und Natural Language Processing

30.03.2022 | News Risk & Analytics Know-how Letter

In Teil II unserer Beitragsreihe zu Einsatzmöglichkeiten von Machine Learning im Kreditrisikomanagement beleuchten wir die Informationsgenerierung aus Texten mittels Methoden des Textmining bzw. Natural Language Processing (NLP).

Grundvoraussetzung jeder Modellierung ist die Verfügbarkeit geeigneter Zeitreihen, sowohl hinsichtlich der Zielvariablen (z. B. Ausfalldaten zur PD-Schätzung) als auch von Variablen, die der Erklärung der Zielvariablen dienen (z. B. Unternehmensgröße, -performance oder Verschuldungsgrad). Falls Daten von externen Anbietern bezogen werden müssen, sind diese in der Regel zwar von hoher Qualität, allerdings häufig auch mit einmaligen oder regelmäßigen Lizenzkosten verbunden. Neben solchen meist quantitativen Informationen stellen qualitative Informationen eine wertvolle Datenquelle dar, die häufig öffentlich und somit kostenlos verfügbar sind. Beispiele derartiger Informationen sind Unternehmensberichte, Risikoberichte, Newsmeldungen, Zeitschriftenartikel oder auch Mitteilungen aus sozialen Medien. Aus Texten extrahierte Informationen können zusätzlichen Erklärungsgehalt liefern und die Prognosegüte von Modellen – nicht nur für das Management von Kreditrisiken – verbessern.

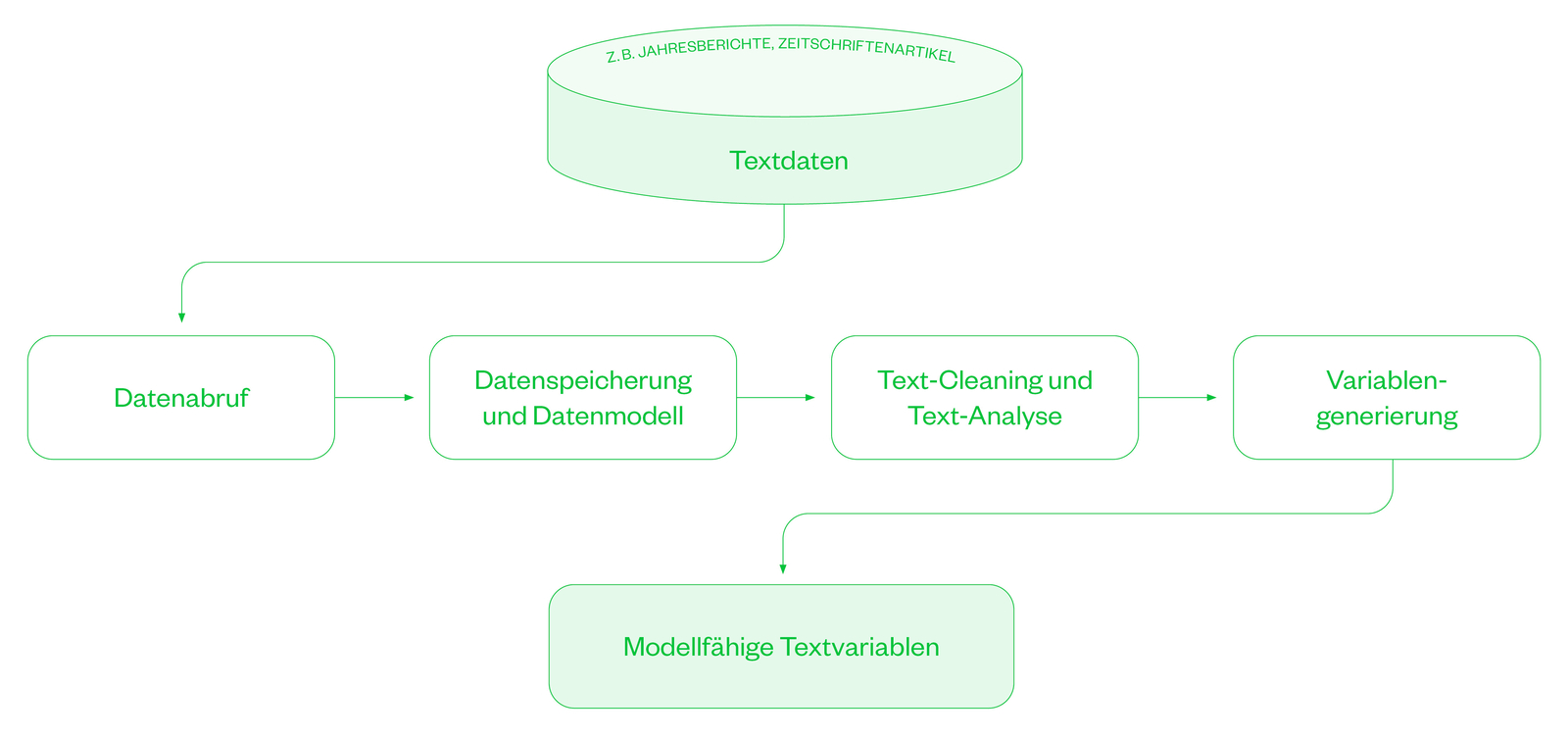

Um diese Daten in den Modellen nutzen zu können, sind eine Reihe von Schritten der Textverarbeitung erforderlich (Abbildung 1), welche idealerweise durch Programmunterstützung (z. B. Python) automatisiert werden.

1) Datenabruf

In Abhängigkeit der Textart kann es zu einer großen Menge an zu verarbeitenden Textdaten, sowohl hinsichtlich der Textlänge als auch der Textanzahl, kommen. Schlagzeilen bestehen beispielsweise meist aus nur wenigen Wörtern, sind aber hochfrequent und erzeugen somit eine große Anzahl an Textdateien. Andererseits sind Jahres- oder Quartalsberichte von Unternehmen gewöhnlich eine zwei- bis dreistellige Anzahl an Seiten lang, ergeben aber durch feste Veröffentlichungszeiträume eine geringere Anzahl an Textdokumenten. Diese unterschiedlichen Eigenschaften der Textarten stellen spezifische Anforderungen an einen programmgestützten, automatisierten Datenabruf, z. B. mittels Webcrawler. Muss sich das Download-Programm dauerhaft im Wartemodus befinden (z. B. Abruf von Newsmeldungen) oder zeitpunktspezifisch arbeiten (z. B. Unternehmensoffenlegung)? Ist eine zentrale Datenquelle (z. B. Zeitschrift, Social-Media-Plattform) heranzuziehen oder liegen mehrere Datenquellen (z. B. Unternehmenswebseiten) vor? Liegen die Daten in generischem Format vor (z.B. Schlagzeilen) oder unterscheiden sich die Textbeobachtungen hinsichtlich Form und Webadresse (z. B. Arten von Unternehmensberichten)? In jedem Fall sollten vor dem Download potenzielle rechtliche Einschränkungen bzgl. der Erlaubnis zum Datenabruf und zur Datenverwendung geprüft werden. Darüber hinaus ist der Zugriff auf Webseiten per Webcrawler nicht immer möglich, falls entsprechende Vorkehrungen zum Blockieren von Anfragen getroffen wurden, die den Datenabzug erschweren.

2) Datenspeicherung und Datenmodell

Die vorzuhaltende Speicherkapazität ist insbesondere abhängig von der Größe und Menge der benötigten Textdaten. Zudem ist vor Start des Downloads ein geeignetes Datenformat (u. a. HTML-, TXT- oder CSV-File), eine Dateinamenskonvention (u. a. Datum, Entität, eindeutiger Identifier) sowie eine sinnvolle Ablage-Struktur (z.B. nach Datum oder Entität) zu identifizieren, wodurch die beabsichtigte Weiterverarbeitung bestmöglich unterstützt wird. Auch das direkte Speichern in Datenbanken (z.B. Access-Datenbank) kann von Vorteil sein, da so ein schnelles Zugreifen und performante SQLAbfragen auf die Informationen möglich werden. Wesentlicher Erfolgsfaktor für weitere Verarbeitungsschritte ist zudem ein gründlich spezifiziertes Datenmodell.

3) Text-Cleaning und Text-Analyse

Vor der Generierung von Textvariablen für die Modellierung ist eine Prüfung und Bewertung der Qualität der abgerufenen Daten sinnvoll. Gab es Fehler beim Download, die zu fehlenden oder fehlerhaften Informationen geführt haben? Entsprechen alle bezogenen Texte dem beabsichtigten Zweck? Ist die Zeitreihe an Dokumenten oder Textbausteinen vollständig? Falls beispielsweise Unternehmensberichte nicht in voller Gänze, sondern nur einzelne Abschnitte daraus (z. B. Risikobericht) verwendet werden sollen, ist zusätzlich das Anwenden von Techniken der Textextraktion (gewünschte Textteile) erforderlich. Je generischer die Struktur der Dokumente, desto einfacher lassen sich dabei Programme (z. B. Python-basiert) verwenden, die den relevanten Text automatisiert anhand der Überschriften oder auch Seitenzahlen einzelner Abschnitte extrahieren. Um möglichst auf den Inhalt der Texte zu fokussieren, sollten grundsätzlich auch Schritte des Text-Cleanings angewandt werden. In der Regel umfasst dies vor allem das Entfernen von HTML-Strukturen, Zahlen (falls nicht von Relevanz) oder Stoppwörtern, d.h. Wörter ohne wesentliche Relevanz hinsichtlich des inhaltlichen Verständnisses des Textes.

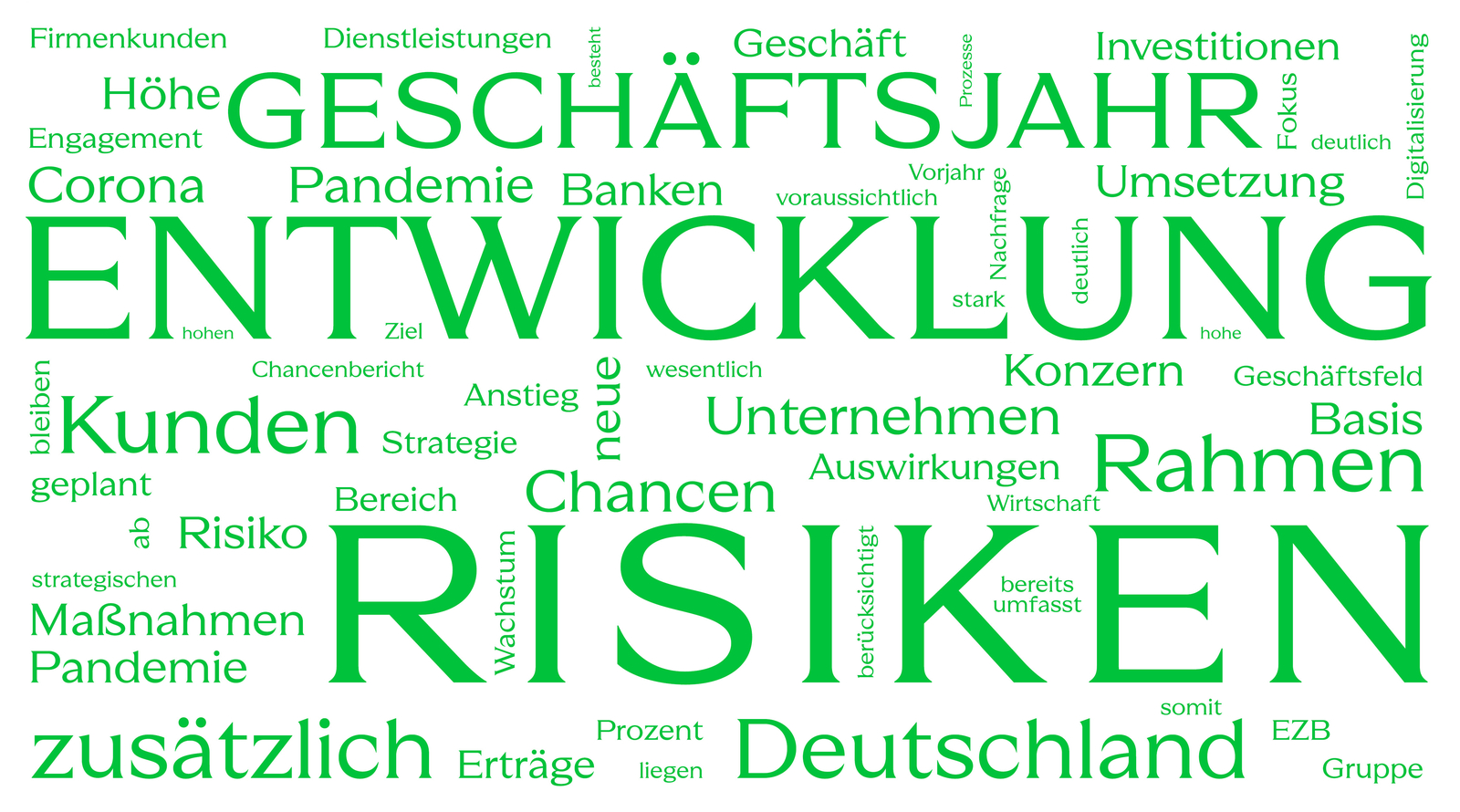

Neben herkömmlichen Kennzahlen der Datenanalyse (z.B. Durchschnitts- oder Häufigkeitsmaße) können textspezifische Visualisierungsmethoden einen schnellen Überblick über die Textdaten verschaffen. Beispielsweise veranschaulicht eine „Word Cloud“ die im Korpus, d. h. der Gesamtheit der betrachteten Texte, am häufigsten vorkommenden Ausdrücke bzw. Wörter (siehe Abbildung 2). Je größer ein Ausdruck dargestellt wird, desto häufiger kommt er im Text vor. Auf diese Weise können beispielsweise im Korpus vorliegende Leitmotive erkannt werden. Das Beispiel einer Word Cloud in Abbildung 2 basiert auf der Auswertung der „Chancen- und Prognoseberichte“ (häufig Teil des Lageberichts) der Jahresberichte deutscher Banken (TOP 10) im Geschäftsjahr 2020. Sehr häufig vorkommende Begriffe wie „Entwicklung“, „Risiken“ oder „Chancen“ sind charakteristisch für Texte, welche die Sicht des Unternehmens auf aktuelle Entwicklungen und den wirtschaftlichen Ausblick beschreiben und somit zukunftsgerichtet sind. Interessant für die Modellierung bzw. weitere Verarbeitung der Texte könnten Leitbegriffe wie „Corona Pandemie“, „Digitalisierung“, „Investitionen“, „Wachstum“ oder „Maßnahmen“ sein.

4) Datenspeicherung und Datenmodell

Auf Basis der aufbereiteten Textdokumente können die Methode(n) zur Textanalyse und -transformation spezifiziert werden. Die Wahl der geeigneten Technik ist dabei insbesondere vom Modellierungszweck und den Vor- bzw. Nachteilen der einzelnen Methodiken abhängig. Verfahren zur Sentiment-Analyse basierend auf Wörterlisten (z.B. Sentiment-Lexikon von Loughran-McDonald für den Kontext „Wirtschaft und Finanzen“) stellen eine schnelle und effiziente Methode dar, um die Dimension der Texte zu reduzieren und deren Stimmung zu quantifizieren. Gleichzeitig sollte das verwendete Dictionary auf den spezifischen Anwendungsfall (z. B. Unternehmensausfall) abgestimmt sein, weshalb die Identifikation bzw. Erstellung geeigneter Wörterlisten eine wesentliche Herausforderung ist, die mitunter teure Ressourcen und Fachwissen erfordern kann. Fortgeschrittene, häufig auf Machine Learning basierende Methoden sind beispielsweise Topic Modeling, d. h. die Extraktion von im Text als relevant identifizierten Themen, oder fortgeschrittene Sprachmodelle (z. B. BERT – Bidirectional Encoder Representations from Transformers). Letztere können dazu verwendet werden, Text in numerische Repräsentationen zu übersetzen, die wiederum von Machine Learning-Verfahren verarbeitet werden können. Während auf diese Weise Textinhalte effizient extrahiert werden können, sind die Textrepräsentation i. d. R. so hoch-dimensional, dass sie nur schwer in traditionellen Methoden (z. B. logistische Regressionen) verwendbar sind. Lösungsansätze können Methode(n) zur Dimensionsreduzierung sein, wie beispielsweise Hauptkomponentenanalyse oder Machine Learning-gestützte Verfahren.

Nagler & Company beschäftigt sich intensiv mit automatisierter Textverarbeitung sowie der Variablengenerierung aus Text mittels verschiedener NLP- und Textmining-Ansätze. Falls auch Sie sich mit interessanten Fragestellungen in diesem Gebiet auseinandersetzen, würden wir uns über einen Austausch freuen. Bei Interesse sprechen Sie uns gerne an!